Quels processeurs pour faire fonctionner l’IA ?

L’intelligence artificielle (IA) a bouleversé notre monde en révolutionnant des domaines aussi variés que la médecine, l’automobile, la finance et les loisirs numériques. Derrière ces avancées se cachent des calculs extrêmement complexes, nécessitant des ressources informatiques colossales. Contrairement aux tâches conventionnelles exécutées par un ordinateur, l’IA repose sur des modèles mathématiques et des algorithmes d’apprentissage automatique qui exigent des performances accrues en traitement parallèle et en manipulation de grandes quantités de données. C’est là qu’interviennent des processeurs spécifiques, conçus pour optimiser ces charges de travail.

Explorerons pourquoi l’IA ne peut se contenter des processeurs standards et en quoi des architectures matérielles adaptées sont indispensables pour maximiser son potentiel. Nous aborderons les principales caractéristiques des processeurs dédiés à l’IA, leur rôle dans le traitement des algorithmes d’apprentissage profond et l’évolution des architectures vers des performances toujours plus optimisées.

L’évolution des besoins en calcul de l’IA

De la CPU à la GPU : une transition nécessaire

Les premiers modèles d’intelligence artificielle fonctionnaient sur des processeurs classiques (CPU – Central Processing Unit), qui équipaient les ordinateurs de bureau et les serveurs. Toutefois, les CPU sont conçus pour exécuter des tâches séquentielles et généralistes. Or, les calculs impliqués dans l’apprentissage profond et le traitement neuronal sont massivement parallélisables.

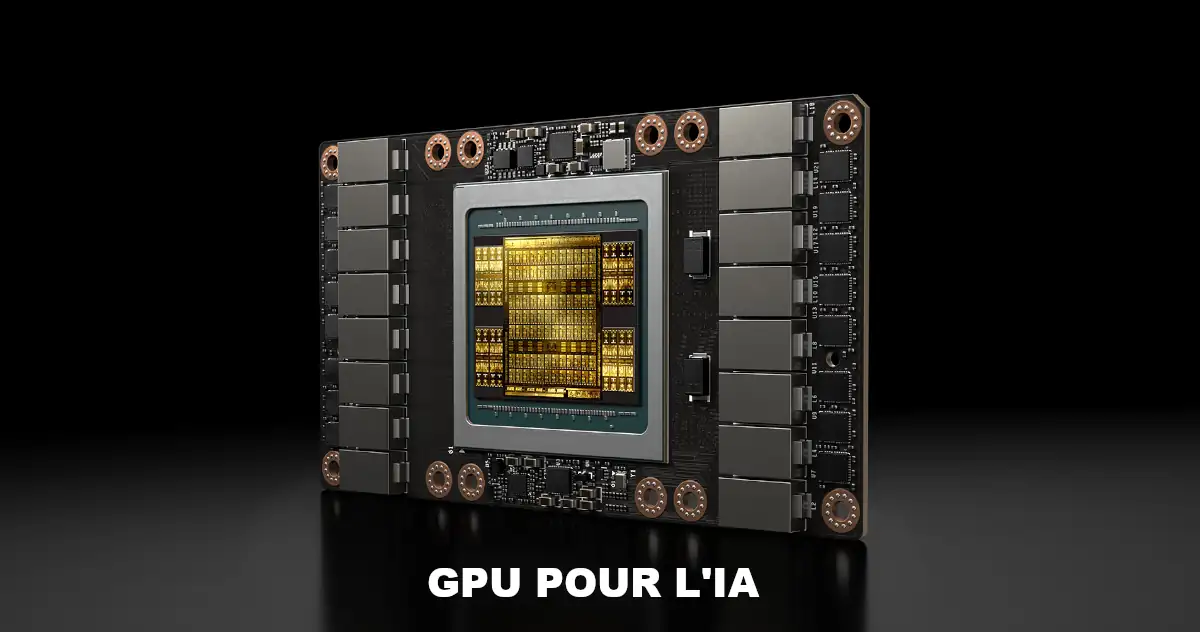

C’est ainsi que les GPU (Graphics Processing Unit), initialement développés pour les calculs graphiques des jeux vidéo, se sont imposés comme une alternative plus efficace. Grâce à leurs milliers de cœurs optimisés pour le traitement parallèle, les GPU permettent d’accélérer les calculs matriciels massifs nécessaires aux réseaux neuronaux.

Vers des architectures spécialisées : TPU, IPU et autres accélérateurs

Bien que les GPU aient offert un bond de performance spectaculaire, ils restent des processeurs conçus pour une utilisation plus large. Afin d’optimiser encore davantage les performances de l’IA, les entreprises du secteur ont développé des unités de traitement spécifiques, comme les TPU (Tensor Processing Units) de Google, les IPU (Intelligence Processing Units) de Graphcore et les NPU (Neural Processing Units) intégrés dans certains smartphones.

Ces architectures sont construites autour d’instructions et de circuits dédiés aux opérations spécifiques du deep learning, améliorant ainsi l’efficacité énergétique et la vitesse d’exécution des modèles d’intelligence artificielle.

Pourquoi l’IA a-t-elle besoin de processeurs spécialisés ?

Optimisation des calculs matriciels et tensoriels

Les algorithmes de deep learning reposent sur la manipulation de matrices et de tenseurs, dont le traitement requiert des milliers, voire des millions d’opérations simultanées. Un CPU, même doté de plusieurs cœurs, ne peut pas rivaliser avec un GPU ou un TPU conçu pour ces calculs massivement parallèles.

Réduction de la consommation énergétique

Un autre enjeu majeur dans le développement de l’IA est la consommation énergétique. Exécuter un modèle d’apprentissage sur un CPU classique peut s’avérer énergivore, alors que des architectures spécialisées offrent un meilleur rendement en consommant moins d’énergie pour la même puissance de calcul.

Diminution de la latence

Dans certaines applications critiques, comme la reconnaissance faciale en temps réel ou la conduite autonome, chaque milliseconde compte. Les TPU et autres accélérateurs sont conçus pour minimiser la latence en intégrant des pipelines de calcul optimisés pour le traitement des modèles IA.

Évolutivité et scalabilité

Les centres de données traitant de vastes volumes de données doivent être en mesure de répartir les charges de calcul efficacement. Les processeurs spécialisés permettent de mieux gérer la montée en puissance des algorithmes d’IA et facilitent l’intégration dans des architectures cloud.

Comparatif des processeurs dédiés à l’IA

| Type de processeur | Fabricant | Architecture | Utilisation principale | Points forts |

|---|---|---|---|---|

| CPU | Intel, AMD | X86, ARM | Tâches généralistes, IA légère | Polyvalent mais limité en calcul parallèle |

| GPU | NVIDIA, AMD | CUDA, ROCm | Deep Learning, Machine Learning | Puissance de calcul massivement parallèle |

| TPU | TensorFlow | Cloud AI, apprentissage profond | Optimisé pour le traitement des tenseurs | |

| IPU | Graphcore | Architecture parallèle avancée | Modèles IA complexes | Très faible latence et efficacité énergétique |

| NPU | Qualcomm, Apple | Processeur intégré | IA embarquée (smartphones, IoT) | Consommation réduite, calcul en périphérie |

L’intelligence artificielle a des exigences de calcul bien spécifiques qui dépassent les capacités des processeurs traditionnels. L’émergence de GPU, TPU, IPU et autres architectures spécialisées a permis de franchir un cap décisif en matière de performances et d’efficacité énergétique. À mesure que les modèles d’IA deviennent plus complexes et gourmands en ressources, ces processeurs sur-mesure continueront d’évoluer pour répondre aux défis de demain.

Les avancées dans ce domaine ouvrent la voie à de nouvelles applications, allant de la médecine de précision aux voitures autonomes, en passant par l’optimisation industrielle et les assistants intelligents. Une chose est sûre : l’avenir de l’IA repose en grande partie sur la capacité de ces processeurs spécialisés à transformer les idées en réalité.

Pour aller plus loin :

À quoi sert l’intelligence artificielle (IA) ?

Comprendre l’IA et le Deep Learning ou apprentissage profond

Peut-on faire confiance à l’intelligence artificielle ?

Comprendre les systèmes de reconnaissance faciale